Множество компаний, занимающихся интернет-продвижением, создают объемные чек-листы и аудиты на сотни страниц формата А4, значительная часть которых — это вода или неэффективные рекомендации. Их внедрение требует немалых усилий и затрат на работу программиста, но в итоге не дает ощутимых результатов. Владельцам сайтов стоит понимать, что качественный технический SEO аудит — это не шаблонный перечень проблем сайта и не просто способ получить «зеленые огоньки» в сервисах проверки. SEO-аудит сайта — это комплексный анализ ошибок и упущенных возможностей ресурса. Результатом является перечень рекомендаций для владельца и технических заданий для программиста, которые после внедрения помогают улучшить видимость сайта в поисковых системах и увеличить трафик по целевым запросам. В этой статье мы раскроем все карты, покажем чек-листы, объясним, что мы делаем и зачем. Время чтения — около 10 минут, но обязательно дочитайте до конца, там вас ждут несколько сюрпризов 🎁 Итак, начнем.

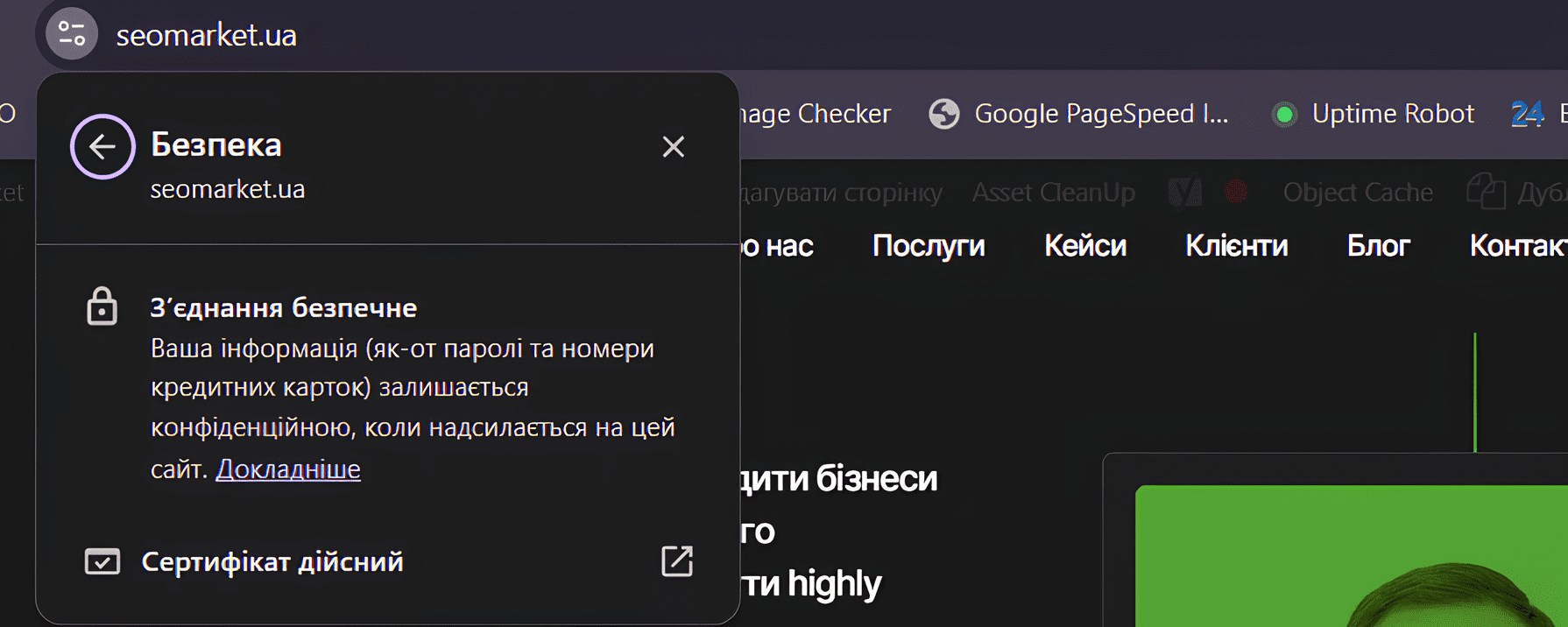

1) Защищённый протокол

Справочник Google по использованию https-версии: Google борется за безопасное использование сайтов для пользователей, и даже представители поисковой системы утверждают, что защищенный протокол дает небольшое преимущество при ранжировании сайта. Порядок действий прост: покупаете SSL-сертификат на хостинге и устанавливаете его на сервере. Важно выбрать правильный сертификат в зависимости от целей (например, будут ли поддомены или несколько доменов). Результатом будет следующее сообщение:

После внедрения важно изменить всю внутреннюю перелинковку на сайте (поскольку у нас теперь новый адрес), исправить встраивание медиаконтента и подключение внешних скриптов, настроить 301 редиректы со старых страниц на новые, а также правильно настроить robots.txt и sitemap.xml. Все это мы детально описываем в нашем SEO-аудите.

2) ЧПУ URL-адреса

При генерации страниц важно использовать правильные URL-адреса (ЧПУ – человекопонятные URL).

❌ Примеры неправильных URL:

➤ site.com.ua/news/2015/10/08/id1235213

➤ site.com.ua/news/2015/10/08/turciya_moderniziruet_zheleznodorozhnuyu_magistral_mezhdu_stambulom_i_granicey_s_bolgariyej_1235213

✔️ Пример правильного URL:

➤ site.com.ua/news/2018/11/02/turciya-moderniziruet-zh-d-magistral-mezhdu-stambulom-i-granicey-s-bolgariyej

Как видно, неправильно, когда, глядя на ссылку, пользователь не может понять, что он увидит, перейдя по ней. Также не рекомендуется использовать нижнее подчеркивание или кириллицу. Для Google нижнее подчеркивание фактически объединяет все слова в URL в единую нечитаемую строку, и вес вхождений ключевых слов в ссылке не будет учтен. Кириллица при копировании и размещении где-либо будет выглядеть вот так:

site.com.ua/news/2015/10/08/%D1%82%D1%83%D1%80%D1%86%D0%B8%D1%8F_%D0%BC%D0%BE%D0%B4%D0%B5%D1%80%D0%BD%D0%B8%D0%B7%D0%B8%D1%80%D1%83%D0%B5%D1%82_%D0%B6/%D0%B4_%D0%BC%D0%B0%D0%B3%D0%B8%D1%81%D1%82%D1%80%D0%B0%D0%BB%D1%8C_%D0%BC%D0%B5%D0%B6%D0%B4%D1%83_%D1%81%D1%82%D0%B0%D0%BC%D0%B1%D1%83%D0%BB%D0%BE%D0%BC_%D0%B8_%D0%B3%D1%80%D0%B0%D0%BD%D0%B8%D1%86%D0%B5%D0%B9_%D1%81_%D0%B1%D0%BE%D0%BB%D0%B3%D0%B0%D1%80%D0%B8%D0%B5%D0%B9_1235213

Неудобно, не так ли?

Подробные требования от Google описаны здесь:

https://developers.google.com/search/docs/crawling-indexing/url-structure

3) Сканирование сайта для проверки ответов сервера

Весь сайт сканируется с использованием собственных скриптов и внешних сервисов, таких как Screaming Frog, для нахождения ссылок с кодами ответа 300, 400 и 500.

Логично, что если пользователь, переходя по ссылкам на сайте, попадает на несуществующие страницы, сталкивается с медленным ответом сервера или долгой загрузкой из-за цепочек редиректов — такой сайт будет неудобным в использовании. Поскольку миссия поисковиков заключается в отображении только самых качественных сайтов в поисковой выдаче, странно звучит «выдача в ТОП поисковой выдачи», указанные проблемы могут помешать занять ТОП. Поэтому при нахождении закономерностей и большого количества ошибок пишется техническое задание для исправления и устранения проблем, выявленных в ходе парсинга сайта.

4) Технические дубликаты

Это важный момент, так как многие CMS имеют особенность генерировать дубли страниц, а для поисковика важно, чтобы пользователю предоставлялась одна, каноничная, основная страница. Если поисковый бот видит две одинаковые страницы на разных URL-адресах, как ему понять, какую страницу показать в ТОП? В таких случаях обе страницы обычно теряют свою ценность в поисковых результатах, уступая место страницам других сайтов без дублей. Поэтому проверяются различные типы дублирования, и составляется техническое задание на исправление этих проблем.

Примеры типов дублей:

➤ Страницы с www и без www (часто сайт доступен по двум адресам, по сути, это два разных сайта для поисковика);

➤ Дубли главной страницы и всех стандартных страниц (разделы, фильтры, продукты);

➤ Дубли с разным расширением страниц (* .php, * .html, * .htm, * /);

➤ Доступность страниц с разным регистром (здесь важно понимать, что существуют реальные проблемы с генерацией таких страниц и уязвимости сайта, поэтому просто так настраивать перенаправление с верхнего регистра на нижний не стоит, могут быть негативные последствия);

➤ Дубли страниц пагинации, сортировки и типов отображения.

Метод закрытия таких дублей зависит от ситуации. Например, можно использовать атрибут rel="canonical" для указания каноничной страницы или мета-тег в зависимости от того, должен ли бот переходить по ссылкам дальше или нет. Пагинацию, например, часто даже не закрывают, а используют для продвижения по региональным запросам. Например, вторая страница оптимизирована под Харьков, третья — под Одессу и так далее.

5) Дублирование текстов

Сайт проверяется на предмет дублирования с внешними источниками и внутренними страницами. Инструменты, такие как candy-content, plagiarismdetector и другие сервисы, мгновенно покажут, есть ли проблема с дублированием контента, а также предоставят список страниц, где эти дубли присутствуют. Наша задача — указать на проблему, найти первоисточник и дать рекомендации по уникализации контента, составить техническое задание для вывода дублирующих блоков контента с помощью скриптов (чтобы поисковики их не видели и не расценивали как дубли), а также скрипты для защиты контента от копирования.

6) Дубли в тегах и мета-тегах

Как известно, не стоит продвигать несколько страниц по одним и тем же запросам, так как это создаёт конфликт релевантности. Это мешает поисковику выбрать одну страницу для показа в топе, хотя есть и исключения. Поэтому мы всегда проверяем наличие одинаковых тегов title, H1, мета-тегов Description, чтобы выявить закономерности генерации дублирования этих данных. После этого составляем техническое задание на исправление ситуации, будь то генерация тегов по шаблонам или написание постраничных названий и других тегов вручную. Всё зависит от CMS и, конечно же, типа сайта. Часто можно увидеть рекомендации по исправлению тега Keywords, но мы рекомендуем их игнорировать, так как программисты тратят время, но в итоге реализация таких тегов никак не влияет на сайт.

7) Robots.txt

Часто можно встретить рекомендации по закрытию ненужных для пользователя страниц через файл robots.txt, но важно понимать, что алиасы, которые вы добавляете в файл, носят лишь рекомендательный характер и не исключают страницы из индекса. Более того, при закрытии страниц мета-тегом robots noindex Google не будет его обрабатывать, и страницы еще долго будут висеть в выдаче с пометкой, что страница закрыта в robots.txt. Таким образом, индекс будет заполнен большим количеством низкокачественных страниц, что может негативно сказаться на продвижении. В то же время, стоит указать в этом файле основной Host домена и ссылку на Sitemap.xml.

Развернутые требования к robots.txt описаны здесь:

https://developers.google.com/search/docs/crawling-indexing/robots/

8) Sitemap.xml

В целом, для небольших сайтов это не обязательный атрибут, но важен для сайтов с большим количеством страниц. В таком файле указывается в XML формате список тех страниц, на которые стоит регулярно ходить поисковому боту, а также указывается частотность обхода. Пишем рекомендации по генерации такой карты сайта, учитывая все нюансы (например, для сайта будет не очень полезно, если в карте сайта будет находиться список на неактуальные отдаленные страницы или дубли важных страниц, на которые будет отправлять Googlebot, тратя краулинговый бюджет).

Развернутые требования к robots.txt описаны здесь:

https://developers.google.com/search/docs/crawling-indexing/sitemaps/build-sitemap

9) Проверка кода сайта

Еще с десятых лет оптимизаторы используют validator.w3.org и подобные сервисы проверки валидации как основной инструмент нахождения ошибок в коде.

Стоит знать, что такие сервисы обновляются крайне редко. Если сравнивать с быстрым развитием веб-разработки, то, используя их, можно как пропустить важные ошибки, так и указать на уже давно неактуальные, снова тратя драгоценное время на их исправление. Наши специалисты проверяют код самостоятельно, в том числе на наличие скрытых элементов на сайте, большого количества закомментированных или пустых строк, оптимальность структуры кода и скриптов, доступность файлов *.css, *.js.

10) Структура сайта

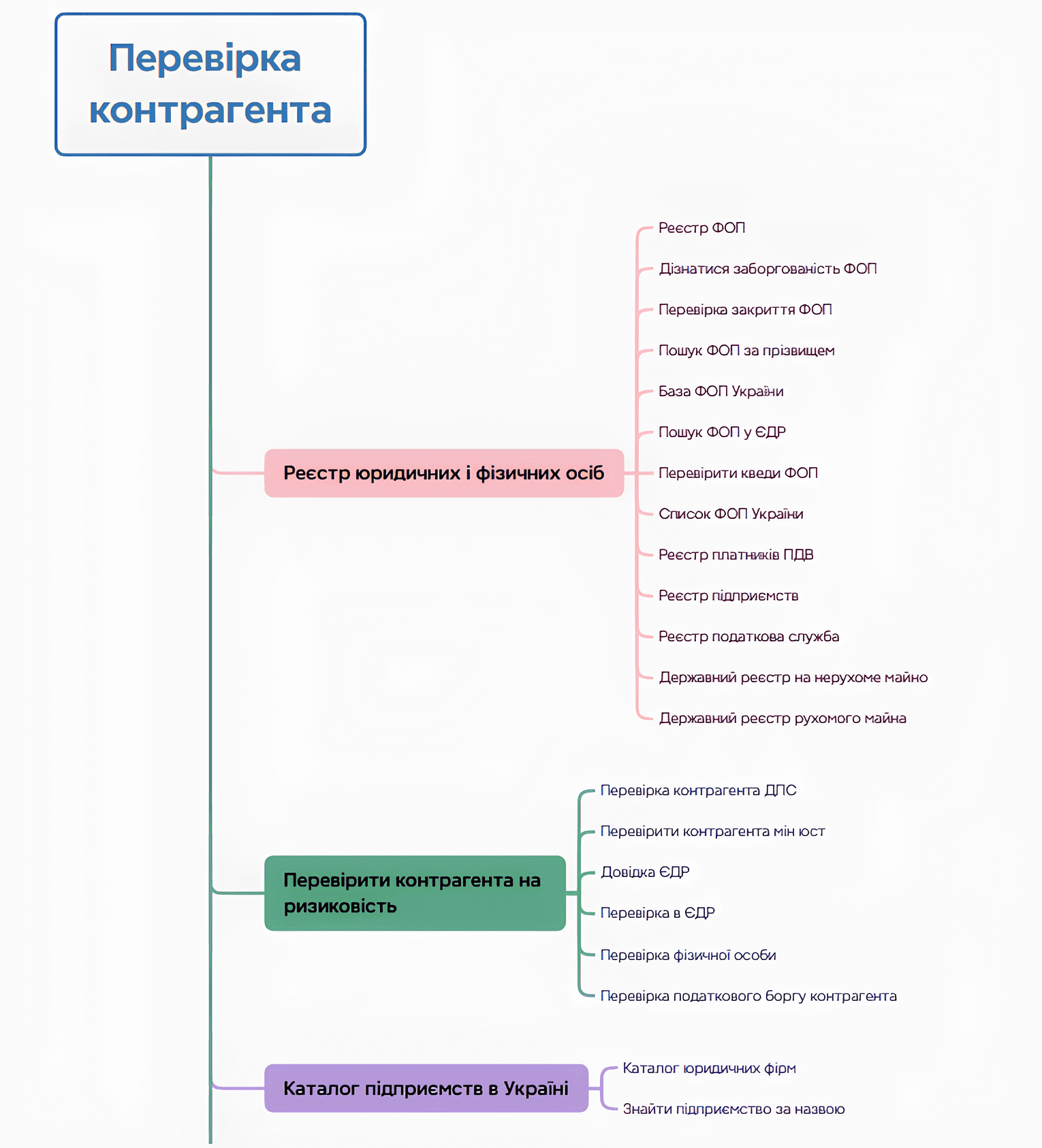

В нашей компании работа по "Составлению структуры сайта" выделена как отдельная услуга, чтобы обеспечить её максимально качественное выполнение. Для этого важно не только проработать видимую на сайте семантику, но и полностью охватить спрос, найти всю семантику ниши и предоставить рекомендации по созданию максимально развернутого сайта с разнообразными посадочными страницами, которые смогут удовлетворить все потребности ниши. Однако в целом оптимизировать структуру сайта без полного сбора семантики вполне возможно, опираясь на логику и опыт. Например, для интернет-магазинов целесообразно создавать страницы фильтрации товаров (например, "Черные ноутбуки" и другие вариации), а для информационных порталов — тэговые страницы. Всё это, конечно, описываем в техническом аудите с требованиями по настройке генерации тэгов, которые важны для правильного ранжирования страниц в поиске. Также необходимо всегда анализировать вложенность страниц, оценивая их доступность для пользователей и поисковых ботов через количество кликов от главной страницы.

Например, если на страницу подраздела можно попасть только на третий клик от главной, переходя по меню или другим блокам, уровень вложенности такой страницы — 4-й. Чаще всего, при наличии конкуренции, это не дает возможности попасть в ТОП1. Поэтому мы даем рекомендации по уменьшению уровня вложенности страниц, внедряя блоки перелинковок по алгоритмам или добавляя дополнительные блоки информации с ссылками на типовых страницах. Вот как примерно выглядит структура сайта для проверки контрагентов (посадочные страницы создаются под разные поисковые запросы):

11) Корректность использования тегов H1 — H6

Тут всё просто: в первом экране следует использовать наиболее высокочастотный ключ в виде названия страницы с тегом H1, кроме того, тег H1 не должен повторяться. Что касается тегов H2 — H6, в целом, их можно использовать как угодно и в любом виде, но стоит помнить две вещи:

➤ Теги <h2> имеют больший вес для поисковика, чем теги <h3> и последующие;

➤ Теги заголовков не стоит использовать в сквозных информационных блоках на сайте, так как они размывают релевантность страницы по ключевым запросам, под которые она оптимизирована.

12) Mobile-friendly

Тенденция последних лет свидетельствует о преобладании трафика с мобильных устройств над десктопным в большинстве ниш. Адаптивная верстка или мобильная версия сайта критически важны для обеспечения удобства использования со смартфонов и планшетов. Получив, например, подтверждение мобильной дружественности от Google, многие SEO-оптимизаторы считают этот пункт выполненным. Однако мы идем дальше: анализируем поведение пользователей на разных устройствах и в браузерах через Google Analytics 4 (GA4), чтобы выявить проблемы совместимости. Часто даже самые привлекательные сайты с высоким процентом мобильного трафика (например, 75%) некорректно отображаются на популярных моделях смартфонов.

Высшим пилотажем оптимизации является обеспечение высоких показателей Core Web Vitals (скорость загрузки, интерактивность, визуальная стабильность), создание прогрессивных веб-приложений (PWA) для улучшения офлайн-доступа и пользовательского опыта, а также оптимизация под голосовой поиск, который набирает популярность.

13) Оптимизация контента под ИИ

Искусственный интеллект влияет на то, как поисковые системы ранжируют контент. Оптимизация под ИИ — это создание релевантного, структурированного материала, который соответствует намерениям пользователей. Мы анализируем запросы с помощью Serpstat или Ahrefs, чтобы охватить как информационные, так и транзакционные потребности, например: «как выбрать смартфон» или «купить ноутбук в Киеве».

➤ Структурируем контент для ИИ: заголовки <h1>–<h3> для четкой иерархии.

➤ Текст делаем короткими абзацами (3–4 предложения).

➤ Создаем списки или блоки FAQ для сниппетов.

➤ Добавляем LSI-ключи (например, «юзабилити» для веб-дизайна), избегая переспама.

Такой подход обеспечивает высокую вероятность того, что ваш контент будет использоваться ИИ.

14) Микроданные Schema.org (микроразметки)

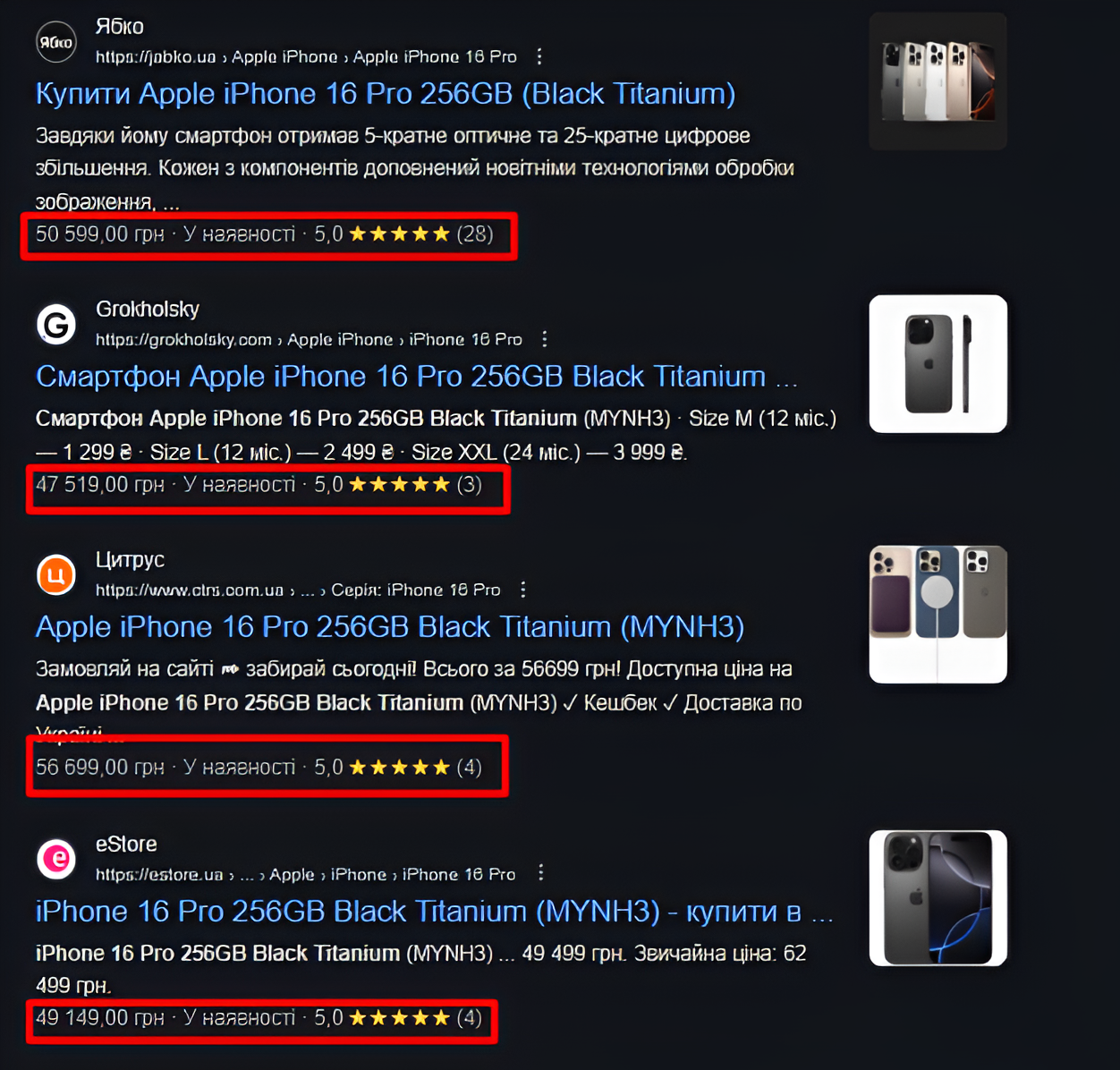

«Хлеб всему голова» для SEOшника, без которого никуда, ведь как люди будут переходить на ваш сайт из выдачи, если он будет представлен как серая мышь? Существует микроразметка для многих блоков информации на сайте: для карточек товаров, для статей, для видео, рецептов, событий, отзывов с рейтингами и т.д. Но лучше один раз увидеть, что это нам дает в выдаче:

Подробнее можно прочитать здесь:

https://developers.google.com/search/docs/appearance/structured-data/search-gallery

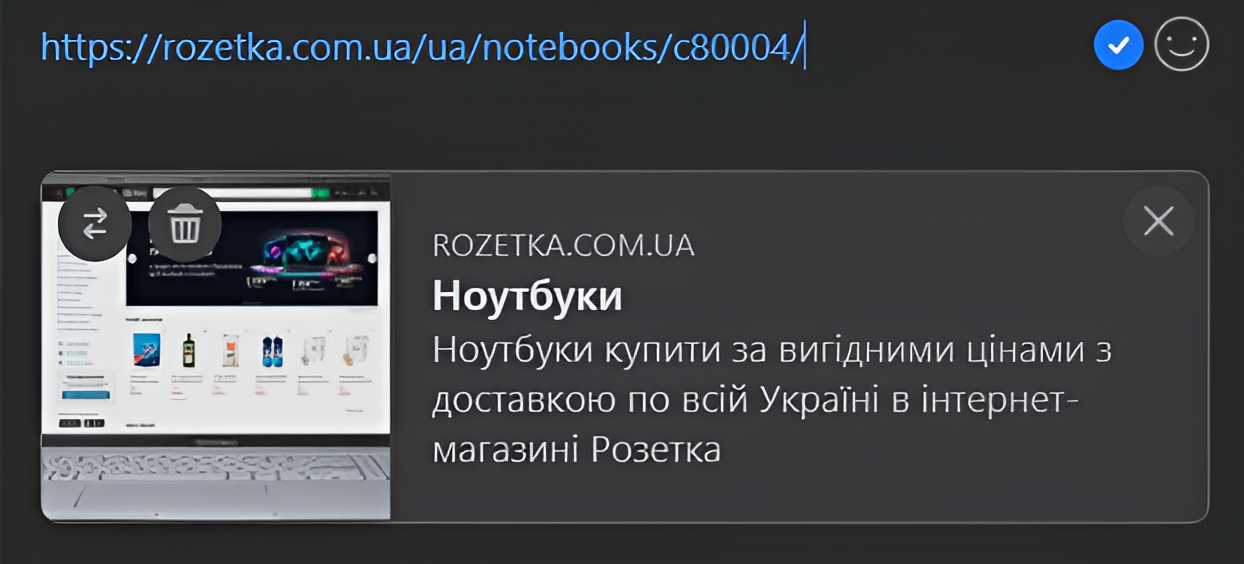

15) Протокол Open Graph

Для корректного отображения публикаций в социальных сетях следует использовать разметку OpenGraph, и не только настроить, но и протестировать, как это будет выглядеть. Если этого не сделать, все шеринги будут выглядеть примерно так:

А после настройки это уже выглядит так:

Кажется, это не совсем про SEO, но не помешает для большего привлечения из социальных сетей и, как следствие, будет плюсом к ранжированию за счет социальных факторов. Инструкции по внедрению здесь: https://ogp.me/

16) Проверка скорости загрузки всех типовых страниц

Здесь проверяем скорость загрузки всех типовых страниц и проводим нагрузочное тестирование, пишем техническое задание по улучшению скорости загрузки, настройке сжатия Gzip, кэшированию файлов, оптимизации изображений, JS и CSS файлов, а также другие рекомендации по ускорению сайта.

17) Анализ поисковой выдачи

Речь идет о изучении результатов поиска по сайту. Если на сайте реализован поиск по запросу, он должен работать всегда. Мы даем рекомендации по исправлению багов, а также разрабатываем алгоритм работы поиска для некоторых нишевых сайтов (например, поиск по VIN-коду для сайтов автозапчастей).

18) Анализ поисковой выдачи по сайту

Речь идет о изучении результатов поиска по сайту. Если на сайте реализован поиск по запросу, он должен работать всегда. Мы даем рекомендации по исправлению багов, а также разрабатываем алгоритм работы поиска для некоторых нишевых сайтов (например, поиск по VIN-коду для сайтов автозапчастей).

19) Анализ наличия ненужных и пустых страниц для пользователей

На сайте могут быть пустые страницы, устаревшие и неинформативные, которые со временем даже создают конфликт релевантности с важными для продвижения страницами. Тот же Screaming Frog показывает количество символов на странице, их размер. Отсортировав по возрастанию, легко можно найти список таких страниц, которые подлежат удалению и редиректам. Также проверяем их наличие в поисковой выдаче.

20) Анализ GSC (Google Search Console)

В каждом проекте наши специалисты при аудите и ежемесячном сопровождении анализируют данные Google Search Console: проверяют наличие технических ошибок, сообщений об индексации, проблемы с мобильной доступностью, Core Web Vitals и т. д. Мы также настраиваем важные параметры — в том числе геотаргетинг (если это целесообразно), контролируем индексацию и, при необходимости, оперативно удаляем конфиденциальные или нежелательные страницы из индекса. Если Google Search Console еще не подключен — предоставляем четкие инструкции или настраиваем его самостоятельно.

21) Проверка тегов, мета-тегов, текстов на заспамленность

Как и проверка на уникальность, проводится проверка на заспамленность. В этом помогает сервис istio.com. После этого проводится ручная проверка, чтобы определить, действительно ли есть переспам и нужно ли его исправлять. Важно не спешить с рекомендациями, пока не будут оценены позиции запросов: если они уже в ТОП-10, то исправления обычно не требуются.

22) Перелинковка

Чек-лист для всех типов внутренней перелинковки следующий:

Меню

➤ Переход на другую языковую версию или регионы

➤ Фильтры категорий

➤ Ссылки на страницы фильтров с характеристиками товара

➤ Хлебные крошки

➤ Конечно же, логотип

➤ Ссылки на товары из категорий

➤ Пагинация

➤ Теги страницы для информационных порталов

➤ Блоки информации, Часто задаваемых вопросов, «Схожих товаров»

➤ «Топ 5 популярных товаров/услуг» для выделения наиболее важных для клиента

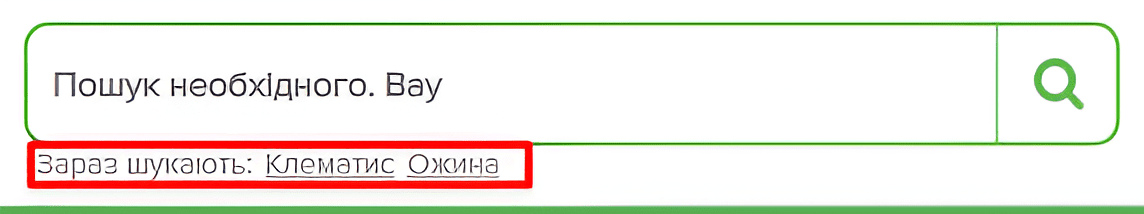

➤ Перелинковка типа «облако тегов», например, под строкой поиска (сюда можно добавлять наиболее приоритетные запросы) для усиления приоритетных запросов

Проверяется не только наличие ссылок на страницы для пользователей, но и для поисковых ботов. Многие блоки на сайте могут загружаться динамически, и из-за отсутствия ссылок в коде поисковые роботы не имеют доступа к этим страницам. Распространенная ошибка: кнопка «показать еще товары» — поисковый бот не видит все товары, которые загружаются динамически, и для Google на вашем сайте всего 12 товаров, а не 312 (если нет доступа к товарам через другие страницы). Также даются рекомендации с точки зрения удобства использования, например, очень неудобно, когда с русскоязычной страницы, переходя на украинскую версию, нас перенаправляют на главную страницу сайта, а не на ту, на которой мы находимся.

23) Проверка корректности цепочки «хлебных крошек»

«Хлебные крошки» – Ваш путь от главной страницы до страницы, на которой вы находитесь, например:

«Хлебные крошки» стоит рассматривать не только с точки зрения удобства для пользователя, но и как блок дополнительной перелинковки. Например, если мы находимся на странице товара «Nokia 3310», в «хлебных крошках» можно отображать не только родительскую категорию «Телефоны-кирпичи», но и страницу фильтра по бренду «Телефоны Nokia» для ее усиления. Еще один способ использовать этот блок в целях SEO – заменить анкор «Главная» на более высокочастотный запрос для продвижения главной страницы по этому ключевому запросу. Например, если главная страница продвигается по запросам «Балконы под ключ», стоит заменить «Главную» в хлебных крошках на этот запрос, и вы получите со всех страниц сайта ссылки с тематическим анкором, что добавит веса указанному запросу.

Что касается микрозаметки, мы предоставляем готовый шаблон кода, который ваши разработчики могут использовать для удобства и снижения стоимости внедрения рекомендаций.

24) Проверка наличия трафикогенерирующих слов на страницах сайта.

Основное правило SEO — если на странице нет вхождений запросов, страница не может ранжироваться по этим запросам или будет ранжироваться ниже конкурентов. Также, если одно и то же слово используется слишком часто, можно попасть под фильтр. Поэтому мы даем рекомендации по добавлению слов в типовые блоки сайта, где вхождение этих слов не приведет к санкциям. Например, добавление слова «цена» ко всем ценам в списке товаров или замена «добавить в корзину» на «купить» повысит релевантность страницы для коммерческих запросов.

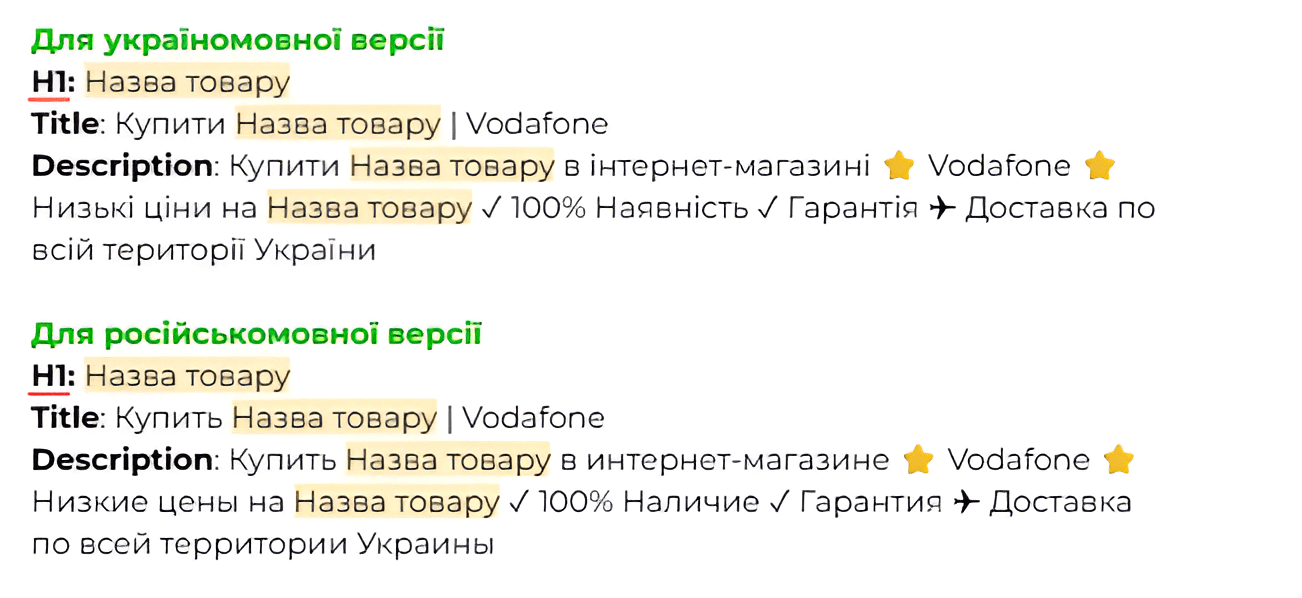

25) Генерація Title, Description, H1

Для крупных сайтов и интернет-магазинов с тысячами однотипных страниц (категории, товары, фильтры) нет смысла прописывать теги вручную — это займет слишком много времени и приведет к потере потенциала страниц, которые не будут оптимизированы на первом этапе. Однако их оптимизация важна, так как теги с ключевыми словами существенно влияют на ранжирование.

На помощь в таких случаях приходит настройка генерации тегов по заданным шаблонам. Проанализировав семантику и найдя закономерности и схожесть для различных страниц (например, что смартфоны, что плиты, ищут с такими словами как «купить», «цена», «Москва» и т.д.), мы создаем шаблоны для генерации тегов с использованием переменной, например, «название страницы», для каждого типа страниц. Например:

➤ для страниц категорий;

➤ разделов;

➤ фильтров;

➤ информационных страниц;

➤ товаров.

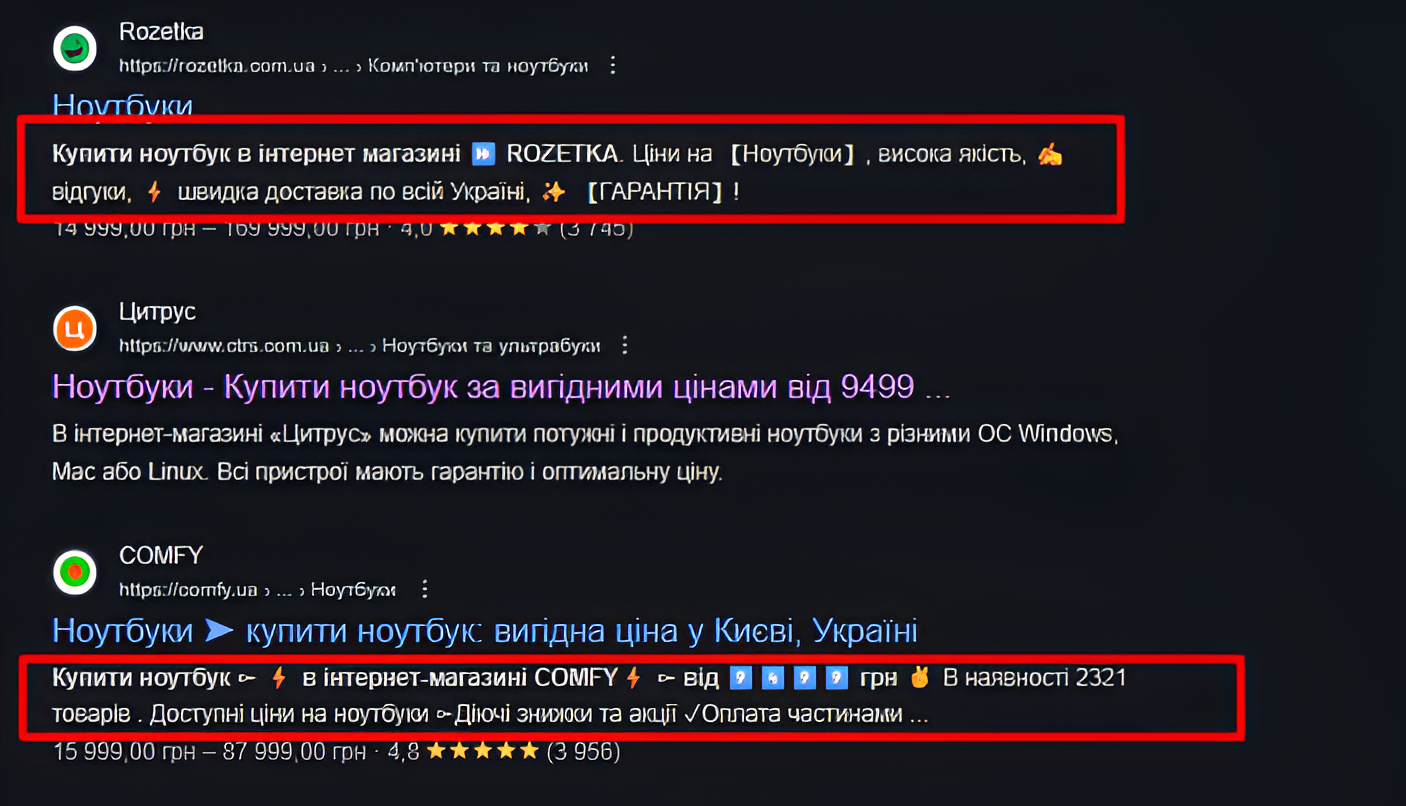

В заголовке H1 следует использовать самый частотный запрос в читаемом виде, в Title — минимум слов с максимальной важностью, а Description, хотя и не влияет на ранжирование, существенно помогает привлекать клики из поисковой выдачи при правильном оформлении (выделенность, привлекательность, релевантность запроса). Также стоит сразу для всех страниц оптимизировать теги H1 в зависимости от нюансов, используя шаблоны или постраничную оптимизацию вручную, так как это даст максимальный эффект.

Например, если страница фильтра называется «Смартфоны – цвет: белый», её лучше переформулировать в виде самого частотного запроса — «Белые смартфоны». А если на сайте тысяча товаров с названием «Красный зонтик», целесообразно добавить артикул — это не только поможет избежать дублирования, но и повысит шансы попасть в ТОП по запросам, в которых указывается именно артикул (да, пользователи ищут и так). Результатом такой оптимизации будет как рост по наиболее важным запросам, так и генерация привлекательных сниппетов, на которые хочется кликнуть, например:

26) Проверка наличия санкций от поисковых систем

В Google Search Console есть раздел «Меры, принятые вручную»

Если в сообщении о «мероприятиях» нет информации, то проверяем аналитику, чтобы выявить скачки трафика вниз в органике за всю историю. В случае обнаружения — проверяем, какие именно страницы или разделы пострадали, оцениваем тексты на заспамленность, проверяем ссылочный профиль по ключевым меткам, чтобы выявить возможные причины санкций. Если проблема с контентом в виде переспама, неуникальности, строим план по замене / устранению такого контента. В случае проблем с ссылочным профилем — отклоняем токсичные ссылки с помощью инструмента Disavow tool. Следует помнить, что на устранение санкций требуется время, в зависимости от нюансов — от нескольких недель до нескольких месяцев.

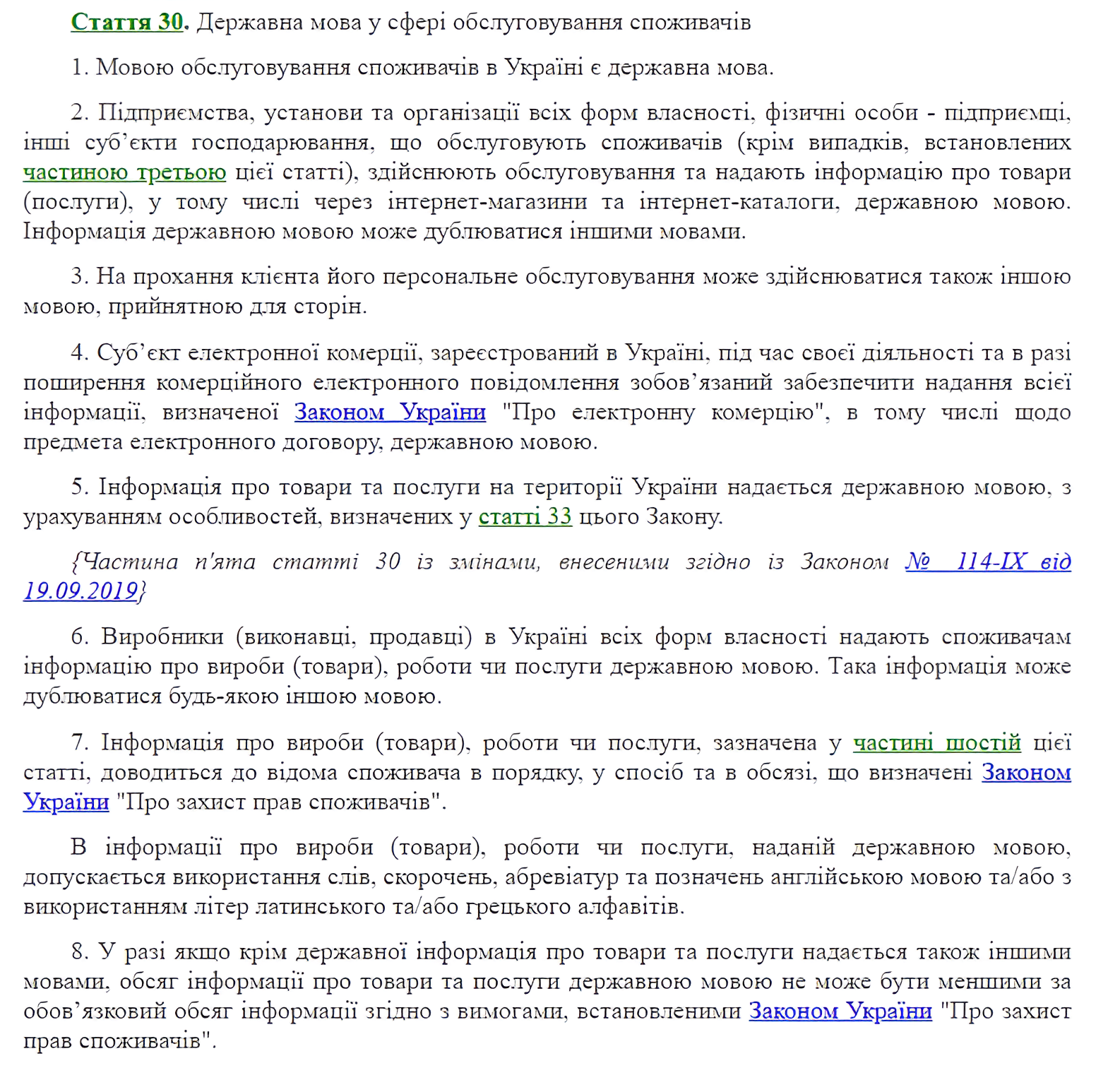

27) Многоязычность и мультирегиональность

Еще один эффективный способ охватить весь поисковый спрос — создание отдельных страниц для разных языков и регионов. Для этого генерируем перевод контента (например, с помощью API Google Translate с последующей ручной правкой), и после публикации языковых версий связываем их между собой с помощью тега hreflang — настроить его поможет удобный генератор:

aleydasolis.com/english/international-seo-tools/hreflang-tags-generator

Что касается региональности, тут сложнее — очень часто возникает вопрос, стоит ли создавать страницы для других стран и городов, или лучше создать поддомен или категорию на сайте, не будут ли такие страницы считаться дублями, или же просто добавить вхождения списка городов на одну страницу. Однозначного ответа здесь нет, всегда стоит анализировать ТОП выдачи и позиции наших запросов, исходя из сложившейся ситуации — рекомендовать необходимые доработки. Например, для информационного портала или сервиса пополнения мобильного телефона не нужно создавать региональные страницы, поскольку, по сути, региональных запросов просто нет. Но для интернет-магазина или сайта услуг часто требуется создание таких страниц.

28) Оптимизация изображений

Согласно данным Google, популярность поиска по картинкам растет. Люди всё чаще ленятся читать информацию, предпочитая увидеть красивое яркое фото и, основываясь на визуальной привлекательности, перейти на нужную страницу. Тот же поиск чайников: иногда гораздо проще просто купить товар, который «будет радовать глаз» каждый день, чем просматривать список однотипных товаров и сортировать их по характеристикам, в которых сам не разбираешься и ещё больше путаешься. А если добавить к этому неидеальную работу фильтрации на сайте, неудобства и несоответствие характеристик, можно вообще остаться без чайника.

Поэтому важно попасть в поиск по картинкам, чтобы покрыть спрос и привлечь людей, которые выбирают товар на основе визуальной привлекательности:

Итак, даём шаблоны генерации тега alt (тега для изображений, на основе которого изображения получают больший вес при ранжировании по запросам) для всех типов фото на сайте с необходимыми переменными.

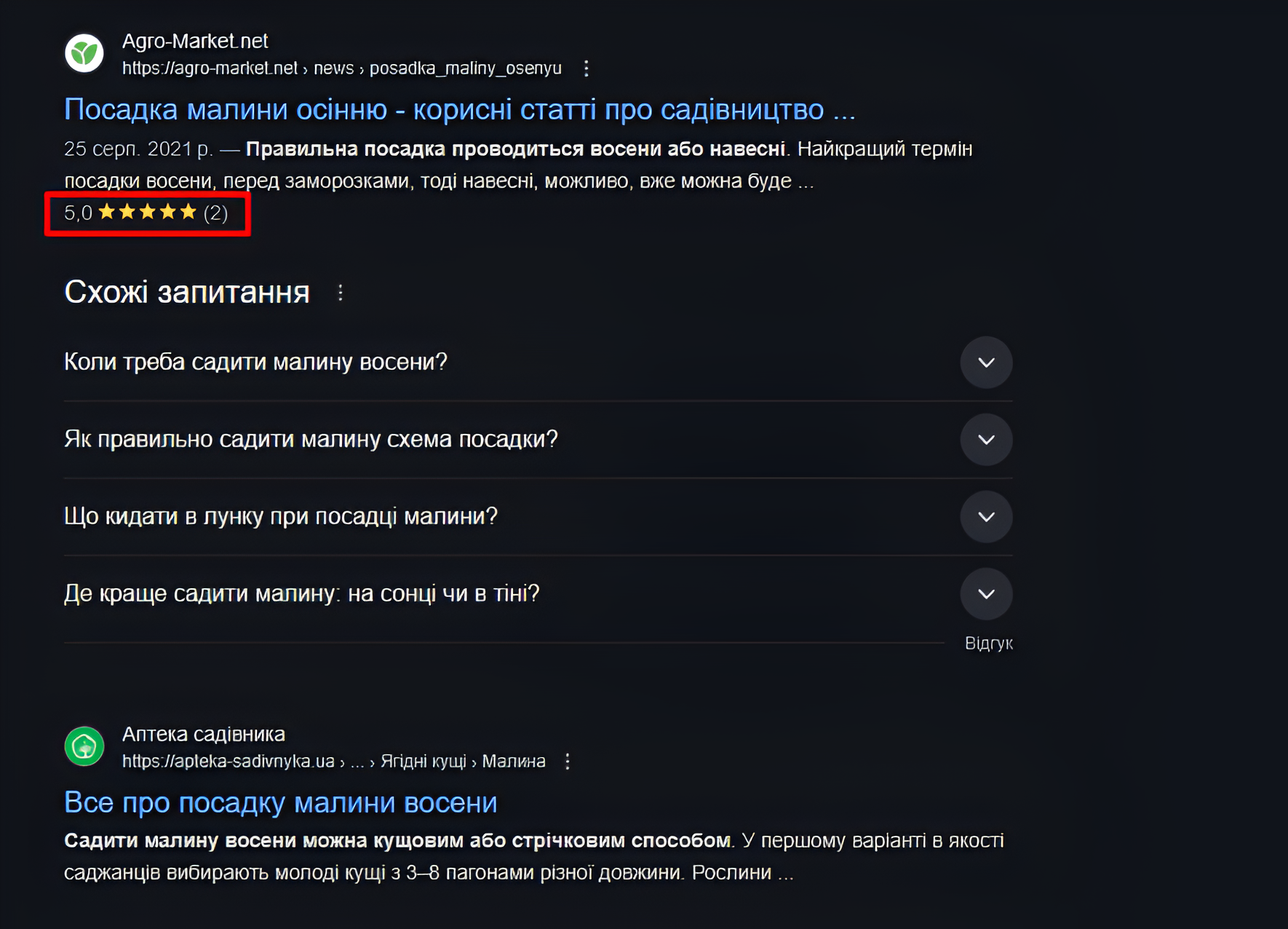

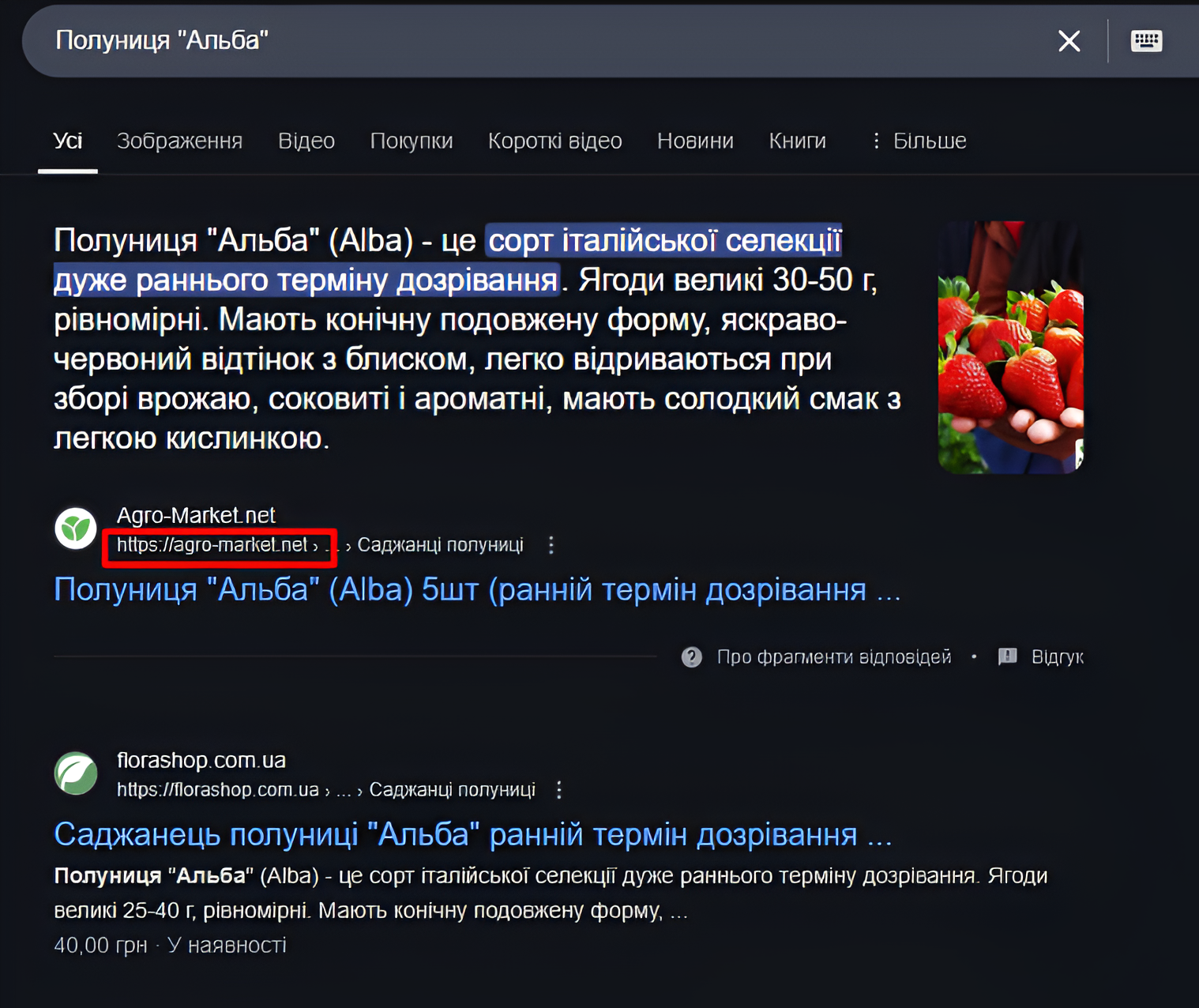

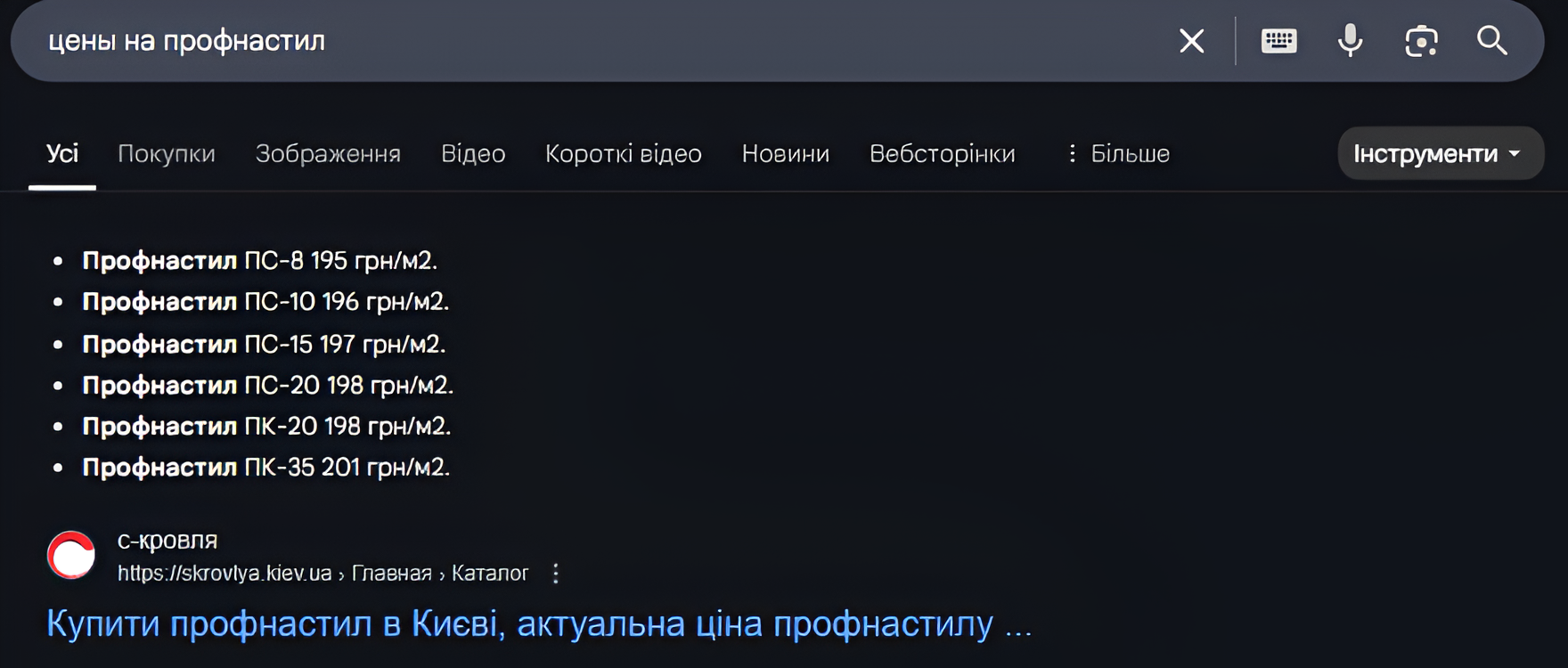

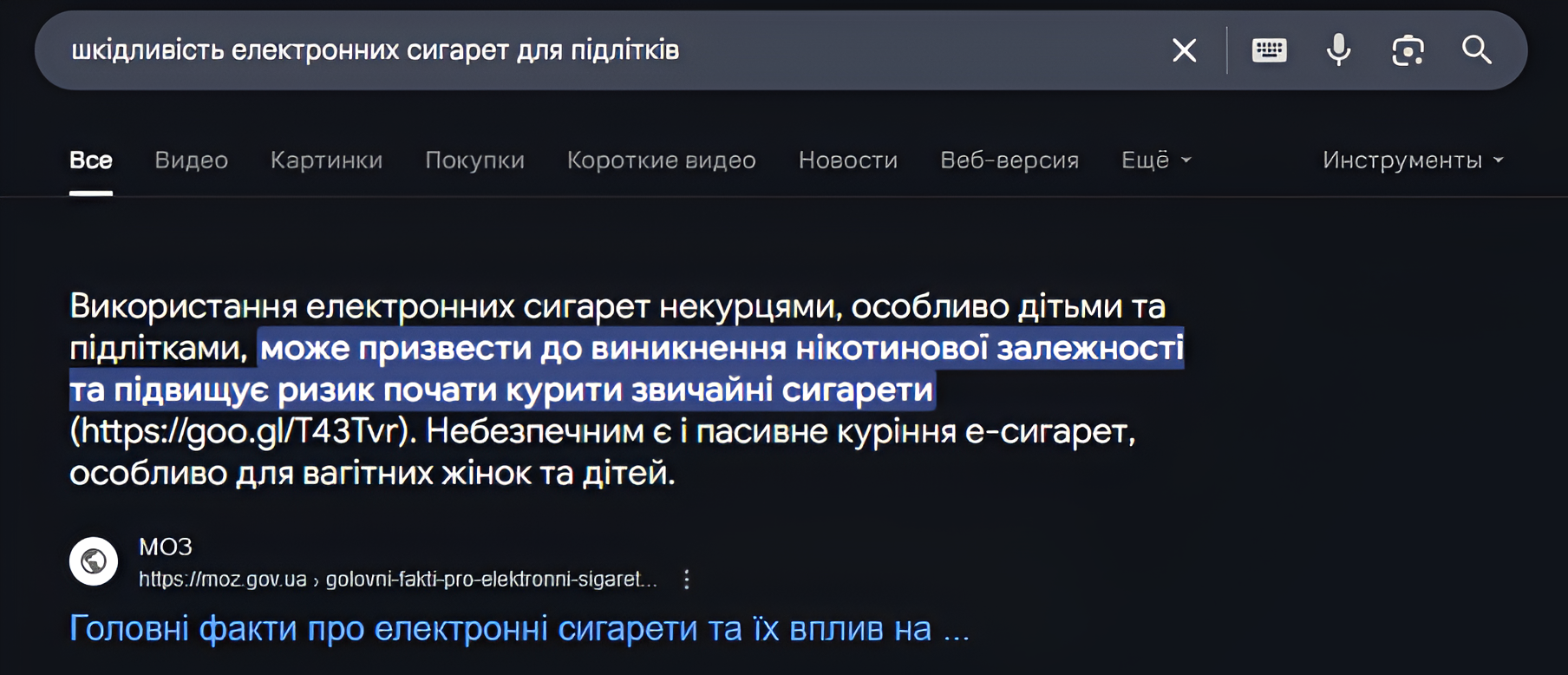

29) Попадание в блок быстрых ответов

Тенденция последних лет — стремление к нулевой выдаче. Примеров множество:

➤ вопрос — ответ

➤ таблицы с ценами

➤ определения

➤ список инструкций

Под все эти типы нам уже удалось найти секрет, как именно попадать в такие блоки. Вот примеры из выдачи для понимания, о чем идет речь:

Заметьте, сайт обычно занимает выдачу как на нулевой, так и на другой позиции в ТОП 10. Также топовые позиции занимает и блок «Похожие запросы», хотя они и косвенно релевантны запросу, но также могут перенаправить пользователя на ваш сайт. Вывод один — нужно писать контент под все возможные информационные запросы в «правильном» виде, тогда и вероятность занять «весь ТОП» будет выше. В аудите описываем методику верстки различных типов контента для попадания в эти блоки.

30) Оптимизация контента под голосовой поиск

Голосовой поиск уже не новинка, но многие до сих пор не адаптируют контент под особенности устных запросов. Люди формулируют вопросы в Google так, как говорят в жизни: например, «где купить лучшую кофеварку во Львове» вместо «кофеварка львов цена».

Для оптимизации мы создаем отдельные блоки в формате «вопрос + четкий ответ», которые соответствуют структуре голосовых запросов. Это повышает шансы попасть в Featured Snippet (нулевую позицию) и делает контент релевантным для голосового поиска. Особенно эффективно это работает со структурированными данными, такими как FAQPage, HowTo или QAPage. Голосовой запрос — это новое «ключевое слово», поэтому контент должен соответствовать именно его разговорной форме, а не только ключевой фразе.

31) Проверка на аффилиаты

Представьте себе ценность двух продавцов на рынке, которые выглядят одинаково, с абсолютно одинаковыми товарами и ценами. А если их будет десять? Это занимает лишнее место и вредит «здоровой конкуренции», свободе выбора потребителя. Владельцы бизнеса будут иметь большую вероятность что-то продать, но кроме владельца в такой ситуации никто не выиграет. Навряд ли такой рынок будет востребован. Эта ситуация в поисковой выдаче называется «аффилированность сайтов», и с этим поисковики активно борются. Если ваша цель — занять как можно больше позиций в ТОПе выдачи, создавая несколько сайтов, важно позаботиться о максимальных отличиях между ними: в дизайне, структуре, контенте, контактной информации и даже в данных whois. В противном случае поисковики могут распознать аффилированность, а наши специалисты выявят эти связи и предоставят инструкции по снятию фильтра аффилиатов. Если два ваших сайта продвигаются по смежным запросам, и хоть чем-то их можно связать — поисковики либо понизят один из них, либо оба по позициям этих запросов.

32) Рекомендации по переезду/выкатыванию сайта

Если вы разрабатываете новый, оптимизированный сайт для замены устаревшего, всегда существует высокая вероятность падения позиций и трафика из-за изменения CMS, URL-адресов, кода сайта, его контента и структуры. Стоит учитывать, что, например, при изменении URL-адресов и переезде на новый сайт без правильных перенаправлений пользователей с старых страниц на новые, пользователь будет попадать на 404 страницы, а вес старых страниц с историей уйдет в никуда. Поэтому, при необходимости переезда сайта, в рамках аудита мы готовим необходимые рекомендации для минимизации вероятности падения трафика и позиций, а также с перенаправлением пользователей с старых страниц на новые (карты редиректов).

33) Другие ошибки

Всегда есть узкоспециализированные, особенные сайты или нюансы, которые не встречаются на типичных сайтах ниши, поэтому в чек-листе всегда присутствует пункт о «других ошибках», который предполагает проверку сайта на нетипичные ошибки и их исправление.

34) Разработка нового сайта

Отдельно стоит упомянуть о нашей услуге «Рекомендации по созданию оптимизированного сайта», разработанные и адаптированные под каждый тип сайта, актуализируются на основе вступных данных от клиента о его бизнесе. Суть этой услуги заключается в экономии средств на разработку нового сайта для продвижения в будущем и ускорении результатов по SEO. Почему это выгодно?

➤ Программистам после создания «красивого» сайта не нужно будет переделывать сайт заново согласно техническому заданию SEO-специалистов, он будет иметь список требований и прямых указаний, благодаря которым разработка будет происходить сразу в соответствии со всеми необходимыми фишками под SEO оптимизацию. Другими словами, вы экономите почти в два раза на разработке и оптимизации сайта, убиваете двух зайцев одним выстрелом.

➤ Большинство экспериментов показало, что при выводе в индекс уже оптимизированного сайта результат по росту трафика значительно выше, чем при выводе «сыро» оптимизированного сайта и его дальнейшем SEO-улучшении. Поисковики видят «качественный» ресурс, понимают, что вы создали готовый продукт для пользователей, и быстрее позволяют ему попасть в ТОП, сокращая срок «Песочницы» (алгоритма, который временно ограничивает попадание новых сайтов в ТОП).

Подведем итог

Все эти пункты чек-листа — это общее описание того, что входит в аудит и почему мы это делаем. Конечно, каждый из них детально разбит на множество подпунктов анализа и практических рекомендаций для технического задания, которое можно передать вашему программисту для выполнения.

Если вы дочитали до конца и схватились за голову, потому что для самостоятельной оптимизации сайта так мало знаний и в то же время так много различной информации в интернете, мы обещаем провести SEO аудит вашего сайта на высшем уровне, основываясь на опыте более ста проектов. Гарантируем, что внедрение наших рекомендаций обеспечит рост трафика уже через несколько недель.

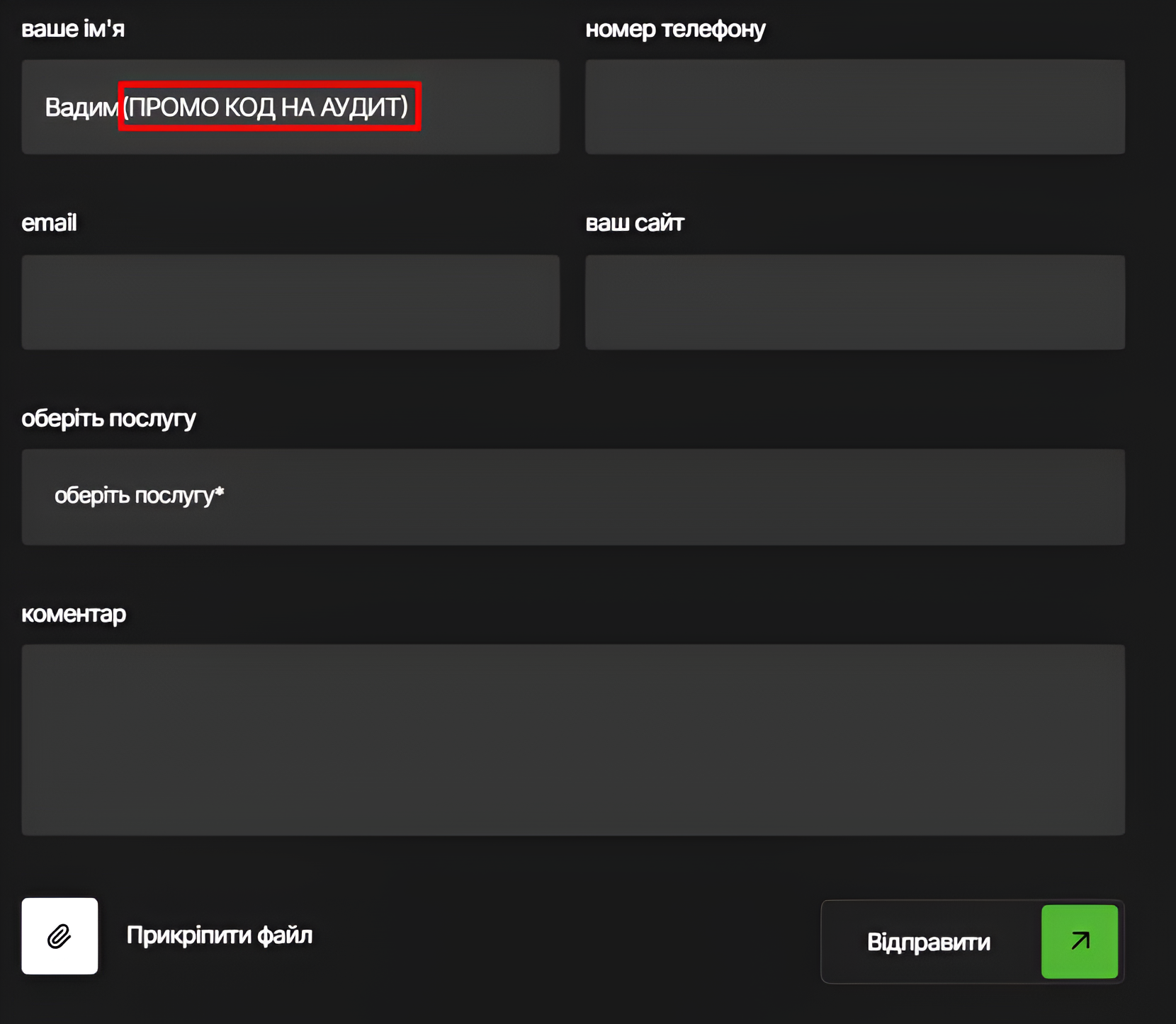

Для героев, которые дочитали до конца, дарим промо-код на скидку 20% на аудит! Введите фразу «ПРОМО КОД НА АУДИТ» в форме заявки на сайте возле имени, как указано ниже. Наши менеджеры свяжутся с вами и предложат выгодное предложение, от которого вы не сможете отказаться!

Если вы заказываете SEO продвижение сайта, аудит на первом этапе продвижения является необходимым условием для оптимального продвижения с наилучшими результатами.

💡P.S.: для тех SEO-гуру, которые найдут в этой статье фишку, благодаря которой эта статья попадает в ТОП выдачи Google, отправляйте нам свои резюме с ответом на E-mail: manager@seomarket.ua, мы всегда ищем таланты!

Автор: Вадим Ивашкевич